¿Cuál es la función primordial de todo teléfono móvil? Hace más de quince años la respuesta a esta pregunta hubiera sido unánime: «Hablar por teléfono».

Antes de que la revolución del smartphone cambiara para siempre la tecnología de consumo (y por extensión el mundo contemporáneo tal y como lo conocíamos), los teléfonos móviles eran precisos y descriptivos en su propósito. Un teléfono, pero uno que se pudiera transportar a todas partes. Herramienta arriba o herramienta abajo, nadie podía exigir mucho más a un Nokia 3310.

Hoy aquella era parece hundida en la neblina de nuestra memoria colectiva. ¿Para qué sirve hoy un teléfono móvil? La respuesta variará enormemente en función de la persona que la elabore. En muchos sentidos, no obstante, un smartphone es hoy un perfeccionamiento de nuestras habilidades biológicas. Una expansión de nuestra vista, un afinamiento de nuestro oído, una multiplicación de nuestras capacidades comunicativas. Es posible entender a los teléfonos móviles modernos como una extensión, como una mejora del ser humano.

Si la frase anterior parece hiperbólica es porque ninguno de nosotros, probablemente, convive con una discapacidad. No necesitamos las modernísimas cámaras de nuestro teléfono para ver; tampoco necesitamos sus sistemas de reconocimiento auditivo para oír; podemos desenvolvernos por nuestra casa sin necesidad de emitir comandos de voz que activen tal o cual electrodoméstico. Es normal. Las personas capacitadas no tendemos a imaginar el mundo tal y como lo viven las personas con discapacidad. Eso no significa que, para ellas, un móvil sí pueda ser una proyección de ellas mismas.

Pocas empresas tecnológicas parecen haber entendido lo anterior con tanto interés como Apple. Su departamento de Accesibilidad lleva en funcionamiento desde 1985, pero no alcanzó su pico de popularidad (y centralidad para la compañía) hasta el iPhone. Es ahí donde Apple moldea sus grandes productos de consumo para que sean adaptables a las personas con discapacidad. Detrás de las funcionalidades que acompañan a sus teléfonos siempre aparecen aplicaciones que tratan de adaptar la tecnología a las personas ciegas o sordas.

Es una política corporativa. Una que le ha granjeado muy buena fama entre las comunidades con discapacidad.

¿A qué obedece su motivación? Nos responde Sarah Herrlinger, directora sénior de Políticas e Iniciativas de Accesibilidad Global de Apple. «Nuestra primera oficina dedicada a las discapacidades abrió en 1985. Por dar algo de contexto, la primera ley de discapacidades estadounidense (American with Disabilities Act) se aprobó en 1990. Creo que es una buena forma de ilustrar que nuestro compromiso con este asunto no se debe a que hubiera una regulación política que nos obligara a hacerlo», explica con orgullo.

Herrlinger sabe de lo que habla. Sus tareas incluyen dirigir los programas de accesibilidad de Apple. «Cuando pensamos en la accesibilidad no pensamos en construir para individuos», desarrolla, «sino que se trata de construir herramientas que sirvan a todo tipo de usos alternativos de la tecnología por parte de la gente». En esa locución («usos alternativos») se encuentra la clave de la accesibilidad: una persona ciega puede utilizar un smartphone, por llamativo que resulte, sólo que de una forma muy distinta a la nuestra.

«Ver» literalmente con un iPhone 14

Como es obvio, Apple blande su iPhone como el argumento definitivo sobre su compromiso con las personas con discapacidad. Todas las versiones de iOS han incluido funcionalidades específicas de algún tipo (el lanzamiento del primer iPhone, de hecho, fue recibido con enorme alborozo y sorpresa por parte de la comunidad invidente), recibiendo mejoras a cada actualización.

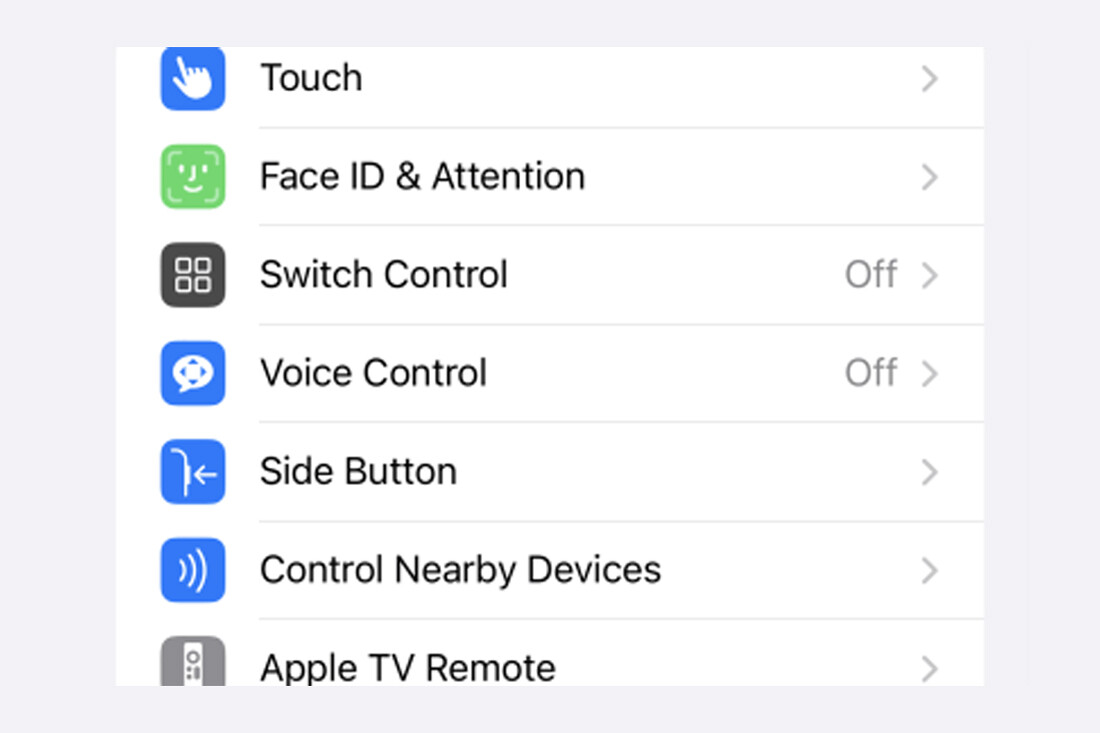

La pantalla de ajustes del iPhone 14, la última versión del teléfono, incluye un capítulo específico dedicado a la Accesibilidad. Las herramientas varían en función de la discapacidad. VoiceOver es una de las más completas y también de las más célebres. Una vez activada, el teléfono lee en voz alta el texto en pantalla, de tal modo que es posible entender qué muestra el teléfono aunque no se disponga de vista. Es altamente personalizable (desde la velocidad de lectura hasta la tonalidad o la pronunciación) y tiene decenas de funciones.

La escritura en braille es quizás la más impresionante de todas. Daniela Rubio es un Apple Distinguished Educator (consultora certificada por la propia compañía que enseña a otros usuarios a utilizar las funcionalidades avanzadas del iPhone) desde hace una década. También es ciega. Su manejo del teléfono es hipnótico. VoiceOver le narra su posición en pantalla en todo momento mientras ella activa y desactiva comandos tanto con la voz como con un teclado en braille.

No hay virtualmente nada que no pueda hacer con el teléfono.

«Podemos teclear en braille sobre la pantalla», explica mientras desplaza sus dedos a toda velocidad. El teclado funciona sobre seis puntos de opresión (tres a cada mano: Rubio agarra el teléfono en horizontal, como si fuera el mando de una videoconsola). «Se calibra en función de tus huellas dactilares, porque puedes tener unas manos muy grandes o pequeñas, como las de un niño», añade.

Rubio considera que las posibilidades del iPhone son inmensas, pero que a menudo la comunidad ciega no logra explotarlas. Es común, por ejemplo, que muchas personas ciegas utilicen versiones más pequeñas del iPhone (mini) porque… ¿Para qué iban a necesitar pantallas de grandes pulgadas si no pueden verla? Para Rubio es una aproximación equivocada: un teléfono más pequeño y antiguo también es un teléfono con peor cámara (para el sistema de reconocimiento de imagen) y funciones.

El teclado braille es otro buen ejemplo. «Es alucinante porque Apple ha incluido distintos tipos de comandos que permiten utilizarlo como un teclado normal», prosigue, «pero es una función que la comunidad invidente en ocasiones ignora porque, por supuesto, tenemos la función dictado». Y dictar es más sencillo que escribir. Para Rubio, sin embargo, el teclado braille permite escribir a gran velocidad en un método de escritura y lectura que la mayor parte de ellos utilizan más allá de sus teléfonos móviles.

Las personas ciegas y sordas son el target natural de Apple cuando hablamos de accesibilidad, en gran medida porque sus discapacidades son relativamente universales. ¿Pero qué hay de las otras muchas personas con discapacidad cuyos problemas son raros o poco comunes? «Los ajustes de Accesibilidad», responde Herrlinger, «es la sección más robusta de todos nuestros dispositivos porque ofrece muchas formas distintas de configuración y personalización». Visión y oído, sí, pero también funciones motoras o cognitivas.

Esta integración de las distintas capacidades existentes tiene su razón de ser, según Herrlinger, y se remonta a la propia fundación de la oficina de Accesibilidad hace casi cuarenta años: «Creo que lo que nos diferencia de los demás es la forma en la que pensamos la accesibilidad. No es una cuestión de cumplimiento, no se trata de marcar una casilla o de hacer el mínimo volumen de trabajo para cumplir con una regulación».

En ese sentido, el iPhone 14 Pro funciona a un tiempo como reclamo y bandera. Sus funciones de accesibilidad engloban también las habilidades físicas y motoras. AssistiveTouch permite adaptar el tacto del teléfono a las necesidades de alguien, por ejemplo, con cierta reducción motora; el control por botón permite utilizar el iPhone activando de forma secuencial los elementos de la pantalla; y FaceID simplifica al máximo el proceso de desbloqueo para alguien que, supongamos, no tenga brazos.

Apple acostumbra a presentar novedades cada año.

¿El huevo o la gallina?

FaceID es un buen ejemplo de la relación de Apple con sus funciones de accesibilidad. El sistema de reconocimiento facial es uno de los principales atractivos del iPhone durante los últimos años, en especial por su exquisita precisión a la hora de desbloquear la pantalla o de permitir pagos de forma instantánea. Es también uno de los principales argumentos de la compañía para promocionar su teléfono sobre la competencia.

Pero también es otra cosa: una herramienta de incalculable valía para millones de personas con discapacidad. ¿Se llega a ella ya otras muchas funciones de accesibilidad a partir del impulso comercial de la compañía o se plantean las innovaciones tecnológicas desde un primer momento con la accesibilidad en mente? Herrlinger se lo piensa unos segundos. «Creo que es una mezcla. No es necesariamente una cosa o la otra», responde.

Parte de esa ambigüedad se debe a la forma en la que Apple trabaja con las comunidades de personas con discapacidad, argumenta. En el área de Accesibilidad trabajan directamente personas ciegas, sordas o con limitaciones motoras. «A veces son nuestros propios empleados quienes dicen: realmente me gustaría que el móvil hiciera esto. Por ejemplo, la función de detectar gente, de entender cuánto está en tus proximidades, vino de uno de nuestros empleados miembro de la comunidad invidente», añade.

Herrlinger se refiere a Lupa, una de las herramientas más redondas del iPhone Pro en materia de accesibilidad. Su perfeccionamiento se aceleró durante la pandemia, un tiempo marcado por el distanciamiento social, algo que, a su criterio, subraya el fuerte feedback bajo el que opera su departamento: «Entendimos rápidamente lo valioso que era para alguien saber cómo de cerca tenías a otra persona. En ese sentido, el desarrollo de las funciones está muy dirigido por la comunidad».

Es decir, hay una sinergia: Apple trabaja en las innovaciones y Accesibilidad busca la forma de integrarlas en un programa integral dedicado a las personas con discapacidad. En ese sentido, Lupa es revelador: su modo de detección utiliza un escáner LIDAR que lee el entorno espacial alrededor del teléfono, transmitiendo la información a su usuario (fue introducido en el iPhone 12 Pro y sólo lo incluyen desde entonces las versiones Pro). Un ciego puede moverse viendo lo que tiene a su alrededor gracias a él; puede detectar una puerta o un escalón; y también puede elegir un vestido rojo por uno verde

Incorporar complejísimas herramientas en un teléfono está muy bien, pero es sólo una parte de la historia. De nada sirve si sus usuarios no saben utilizarlas. Es ahí donde el rol de personas como Rubio torna en crucial para Apple: «Al principio, cuando mis alumnos cogen un iPhone por primera vez, se asustan porque es plano. No tiene botones. Pero hay una curva de aprendizaje. Es fácil imaginar los gestos porque son muy intuitivos». También pueden trasladarlos una vez personalizados a otros dispositivos de Apple.

También hay un ejercicio de divulgación. La accesibilidad no es ajena al gran dilema de la tecnología de consumo (a mayor complejidad, mayor dificultad permeando en el usuario masivo). «Al principio [de los smartphones y del iPhone] fue muy impactante porque mucha gente no era consciente de las funciones de accesibilidad. Hoy la mayoría de personas ciegan utilizan iPhone o dispositivos con iOS. Y utilizan la tecnología, pero creo que hay muchas cosas que no explotan porque no saben utilizarlas», se lamenta.

Su trabajo, subraya, es educarles. ¿Convendría utilizar funciones más simples? «Sí, muchos ciegos tienen el iPhone SE porque es más simple. Pero si yo tuviera el SE no podría detectar a otra gente cuando se acerca», razona. También se refiere a la cámara del iPhone 14 Pro, mucho más completa y precisa. La suma de mayor resolución y VoiceOver le permite fotografiar su entorno y escuchar una descripción de lo captado. Abre una fotografía en su móvil, de sus hijos, y el teléfono la narra con todo lujo de detalles. Es un ejercicio fascinante por la naturalidad y la precisión con la que lo ejecuta.

«Si tengo una mejor cámara, podré ver mejor. Es como tener un par de pequeños ojos», añade entre risas. VoiceOver, entre tanto, sigue explicando la imagen y ubicando espacialmente todos los elementos de la foto. Sus hijos incluidos.